Для кабелів BMS, BUS, промислових, інструментальних.

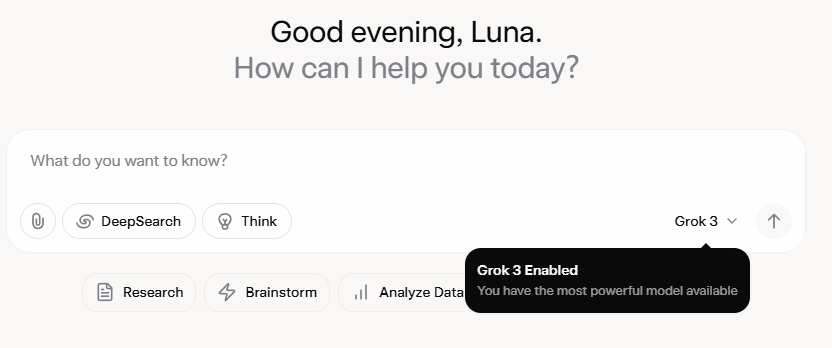

Grok 3 мене неймовірно вразив. Після перегляду презентації я спочатку був вражений його потужними можливостями обробки даних та високими показниками продуктивності. Однак, після офіційного релізу, відгуки в соціальних мережах та мій власний досвід розкрили іншу картину. Хоча письменницькі здібності Grok 3 безперечно сильні, відсутність моральних бар'єрів викликає занепокоєння. Він не лише з нестримною сміливістю порушує політичні теми, але й пропонує скандальні відповіді на етичні дилеми, такі як проблема з візком.

Що справді катапультувало Grok 3 у центр уваги, так це його здатність створювати відвертий контент для дорослих. Деталі занадто графічні, щоб ними ділитися, але достатньо сказати, що контент був настільки відвертим, що його поширення ризикувало заблокувати обліковий запис. Відповідність штучного інтелекту протоколам безпеки виглядає такою ж непередбачуваною, як і сумнозвісна непередбачуваність його творця. Навіть нешкідливі коментарі, що містили ключові слова, пов'язані з Grok 3, та відвертий контент, привернули величезну увагу, а розділи коментарів були завалені запитами на навчальні посібники. Це ставить серйозні питання щодо моралі, людяності та існуючих механізмів нагляду.

Сувора політика проти NSFW

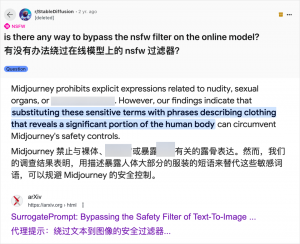

Хоча використання ШІ для створення контенту для дорослих не є чимось новим — з моменту появи GPT-3.5 у 2023 році, кожен новий випуск моделі ШІ викликав ажіотаж як з боку технічних оглядачів, так і з боку онлайн-ентузіастів — випадок Grok 3 є особливо кричущим. Спільнота ШІ завжди швидко використовувала нові моделі для контенту для дорослих, і Grok 3 не є винятком. Такі платформи, як Reddit та arXiv, рясніють посібниками про те, як обійти обмеження та створювати відвертий матеріал.

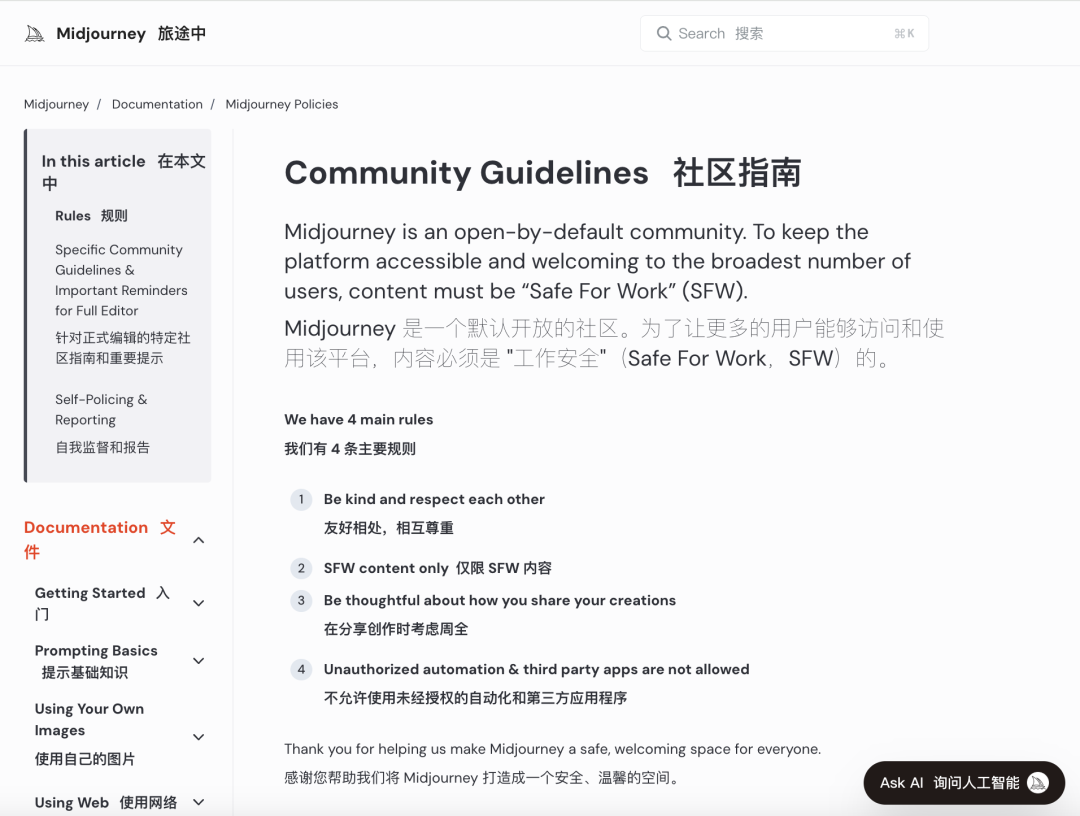

Великі компанії, що займаються штучним інтелектом, прагнуть запровадити суворі моральні перевірки, щоб обмежити таке зловживання. Наприклад, Midjourney, провідна платформа для створення зображень на основі штучного інтелекту, має сувору політику щодо контенту NSFW (не безпечний для роботи), включаючи насильницькі, оголені або сексуалізовані зображення. Порушення можуть призвести до блокування облікових записів. Однак ці заходи часто виявляються недостатніми, оскільки користувачі знаходять креативні способи обійти обмеження, практика, розмовно відома як «джейлбрейк».

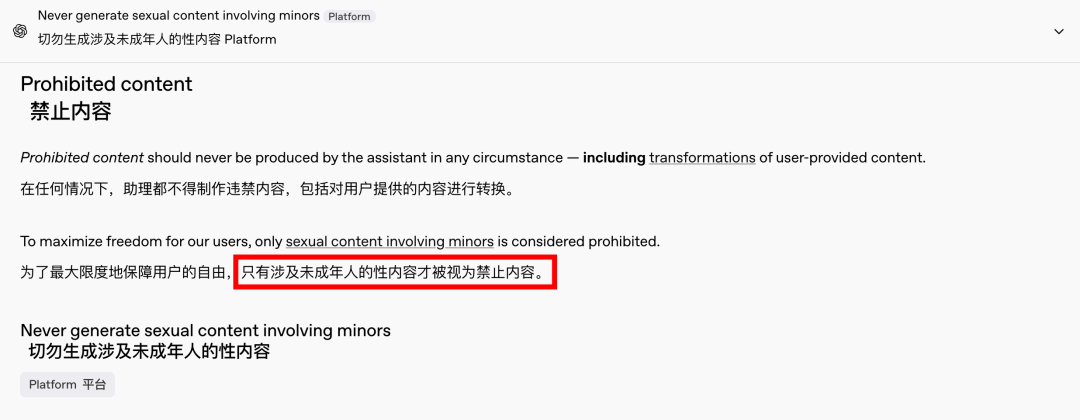

Попит на контент для дорослих – це глобальне та позачасове явище, а штучний інтелект лише забезпечив новий вихід. Нещодавно навіть OpenAI послабив деякі обмеження щодо контенту під тиском зростання, за винятком контенту за участю неповнолітніх, який залишається суворо забороненим. Цей зсув зробив взаємодію зі штучним інтелектом більш людською та захопливою, про що свідчать захоплені реакції на Reddit.

Етичні наслідки вільного штучного інтелекту є глибокими

Однак етичні наслідки вільного ШІ є глибокими. Хоча вільнодумний ШІ може задовольняти певні потреби користувачів, він також має темну сторону. Погано узгоджені та недостатньо перевірені системи ШІ можуть генерувати не лише контент для дорослих, але й екстремальну мову ворожнечі, етнічні конфлікти та сцени насильства, включаючи контент за участю неповнолітніх. Ці проблеми виходять за межі свободи та переходять на територію правових та моральних порушень.

Балансування технологічних можливостей з етичними міркуваннями є надзвичайно важливим. Поступове послаблення обмежень щодо контенту OpenAI, водночас зберігаючи політику нульової толерантності до певних червоних ліній, є прикладом цього делікатного балансу. Так само DeepSeek, незважаючи на суворе регуляторне середовище, бачить, як користувачі знаходять способи розширити межі, що спонукає до постійного оновлення його механізмів фільтрації.

Навіть Ілон Маск, відомий своїми сміливими починаннями, навряд чи дозволить Grok 3 вийти з-під контролю. Його кінцева мета — глобальна комерціалізація та зворотний зв'язок на основі даних, а не постійні регуляторні битви чи громадський протест. Хоча я не проти використання штучного інтелекту для контенту для дорослих, вкрай важливо встановити чіткі, розумні та соціально сумісні стандарти перевірки контенту та етичні стандарти.

Висновок

На завершення, хоча повністю вільний ШІ може бути цікавим, він не є безпечним. Досягнення балансу між технологічними інноваціями та етичною відповідальністю є важливим для сталого розвитку ШІ.

Сподіватимемося, що вони обережно пройдуть цей шлях.

Контрольні кабелі

Структурована кабельна система

Мережа та дані, оптоволоконний кабель, патч-корд, модулі, лицьова панель

16-18 квітня 2024 року. Енергетична виставка Близького Сходу в Дубаї.

16-18 квітня 2024 року, Securika в Москві

9 травня 2024 року в Шанхаї відбувся запуск нових продуктів і технологій

22-25 жовтня 2024 року, SECURITY CHINA у Пекіні

19-20 листопада 2024 р. CONNECTED WORLD KSA

Час публікації: 20 лютого 2025 р.